英偉達發布新人工智能芯片 展示黑科技香港新聞網8月9日電 北京時間周二(8日)晚間,英偉達宣布推出一款新芯片,旨在在人工智能硬件領域抵禦競爭對手,包括AMD、谷歌和亞馬遜。期間提及一系列與生成式AI浪潮息息相關的硬件和軟件服務。

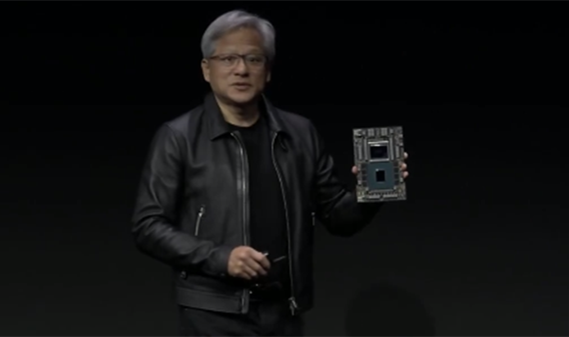

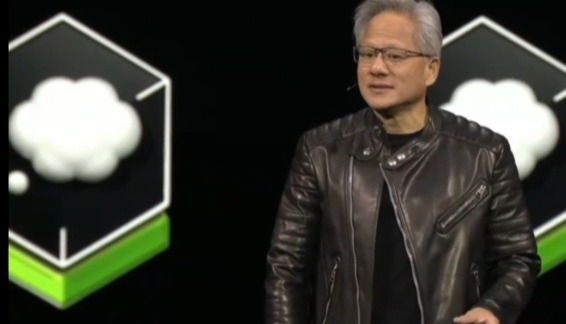

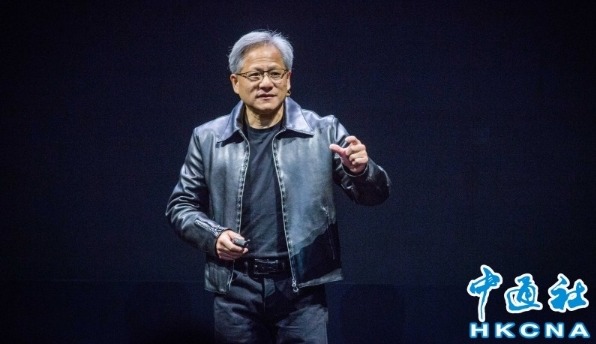

英偉達發佈新人工智能芯片GH200 視頻截圖 新芯片專為全球數據中心規模而設計 英偉達聯合創始人兼CEO黃仁勛時隔5年再度登上SIGGRAPH的舞台發表主旨演講,提及一系列與生成式AI浪潮息息相關的硬件和軟件服務。目前英偉達在AI芯片市場佔據了超過80%的市場份額。 該公司的專長是圖形處理單元(GPU),已成為支撐生成式人工智能軟件(如谷歌的Bard和OpenAI的ChatGPT)的大型AI模型的首選芯片。但由於科技巨頭、雲服務提供商和初創企業爭奪GPU容量來開發自己的AI模型,英偉達的芯片供應短缺。 英偉達最新發布的芯片為GH200,與該公司目前最高端的AI芯片H100采用相同的GPU。但GH200還配備了141GB的尖端內存和一個72核的ARM中央處理器。 英偉達CEO黃仁勛在演講中表示:“我們給這個處理器加了一些提升。”他補充說:“這個處理器是為全球數據中心的規模而設計的。” 據黃仁勛透露,這款新芯片將於明年第二季度在英偉達的經銷商處上市,並計劃在年底前提供樣品。英偉達的代表拒絕透露價格。 大型語言模型的推理成本將大幅降低 通常,處理AI模型的過程至少分為兩個部分:訓練和推理。 首先,使用大量數據對模型進行訓練,這個過程可能需要數月時間,有時需要數千個GPU,例如英偉達的H100和A100芯片。 然後,該模型將在軟件中用於進行預測或生成內容,這個過程稱為推理。與訓練類似,推理需要大量的計算資源,並且每次軟件運行時都需要大量的處理能力,例如生成文本或圖像時。但與訓練不同,推理是幾乎持續進行的,而訓練只在需要更新模型時才需要進行。 黃仁勛表示:“你可以將幾乎任何大型語言模型放入其中,它將進行瘋狂的推理。大型語言模型的推理成本將大幅降低。” 新芯片GH200專為推理而設計,因為它具有更大的內存容量,可以容納更大的AI模型在單個系統中。英偉達副總裁伊恩·巴克在與分析師和記者的電話會議上表示,英偉達的H100具有80GB的內存,而新的GH200則有141GB的內存。英偉達還宣布推出了一種將兩個GH200芯片組合到一台計算機中的系統,以支持更大的模型。 巴克表示:“更大的內存使得模型可以常駐在單個GPU上,而不需要多個系統或多個GPU來運行。” 新科技迭出 AI算力和能力更強大 SRAPH由ACM SRAPH(計算機協會計算機圖形圖像特別興趣小組)舉辦,是計算機圖形學的年度頂級會議。 黃仁勛表示,時隔五年,再次站在這個台上,當年發布顯卡時他可以把顯卡拿在手上展示,現在由Grace Hopper芯片組成的產品只能放在台子上展示了。 這次發布會上,黃仁勛同時通過動畫展示如何使用NVLink等技術,構建出一整套為生成式打造的超級計算機系統。他表示,新的芯片出來後,只需要花800萬美元采購210套GH200,就能達到與1億美元CPU數據中心同等的AI算力。 同時,英偉達也展示了其Omniverse的平台。Omniverse是Nvidia創建的實時3D圖形協作平台,主要的功能就是創建“數字孿生”,在虛擬世界中模擬現實。 黃仁勛以世界最大廣告公司WPP和比亞迪(騰勢汽車),作為Omniverse雲和生成式AI的使用案例。WPP通過Omniverse為騰勢N7打造了一個實時、囊括各種外觀配置的汽車“數字孿生”,並能够通過Adobe等提供的AIGC功能修改宣傳材料的圖像背景。 除此之外,英偉達的Hugging Face(俗稱“抱抱臉”)的共享機器學習模型和數據集平台、AI 工作台以及為企業用戶提供生成式所需工具的最新版本企業軟件平台NVIDIA AI Enterprise 4.0也出現在發布會上。 據了解,此次宣布正值英偉達的主要GPU競爭對手AMD推出面向AI的芯片MI300X,該芯片支持192GB的內存,並被市場推廣為適用於AI推理。谷歌和亞馬遜等公司也正在設計自己的定製AI芯片用於推理。英偉達這次宣布推出一款新芯片,旨在人工智能硬件領域抵禦競爭對手。(完) 【編輯:梅婉潼】

|